最近更新于 2025-08-23 12:27

项目地址:https://github.com/Byaidu/PDFMathTranslate

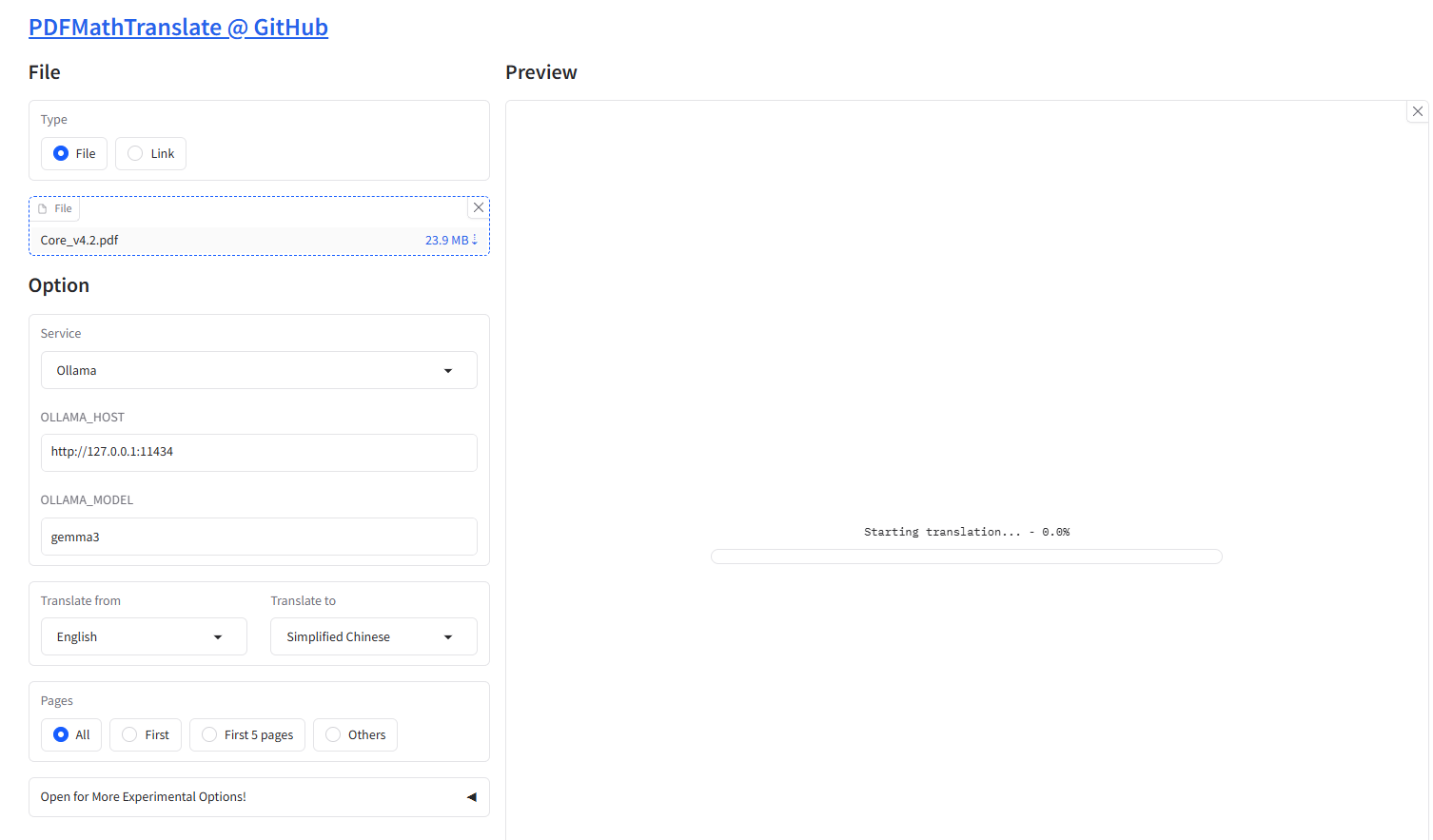

最近打算研究下蓝牙,但是蓝牙的核心规范就是两千七百多页,还有各种各样的细则文件,英文文件看起来也头疼。谷歌翻译虽然可以免费翻译 PDF 文档,但是仅限于不超过 10M 大小的文件,我尝试压缩 PDF,大小也压不到 10M 以下。

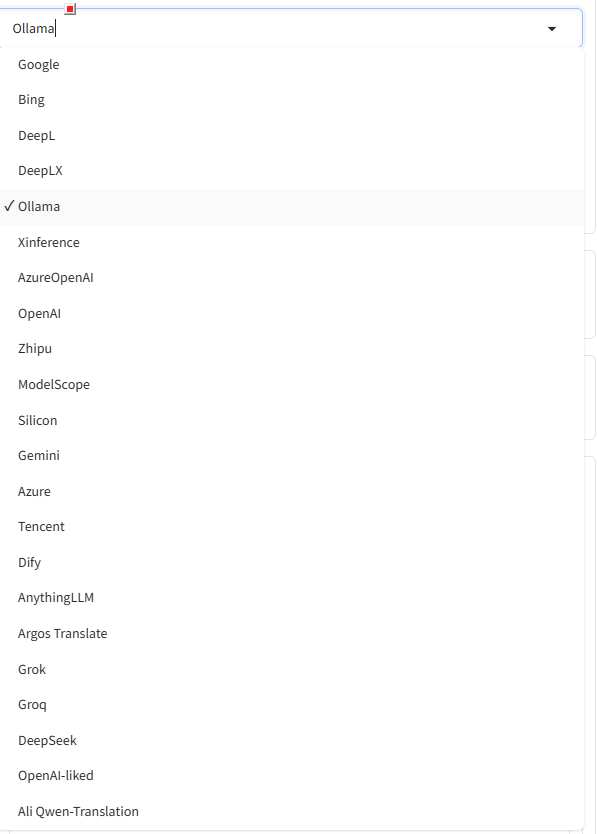

然后发现了这个开源项目,支持使用谷歌、必应等翻译引擎,也可以使用本地 AI。

我开始尝试使用谷歌引擎(设置代理可以参考我回复的:https://github.com/Byaidu/PDFMathTranslate/issues/973#issuecomment-3048761248 ),但是这个文件太大,翻译到后面就报错(我猜测可能是翻译太频繁,被谷歌翻译的服务器识别出是“机器人”,就禁止访问了)。我就尝试了自己部署 Ollama:https://github.com/ollama/ollama

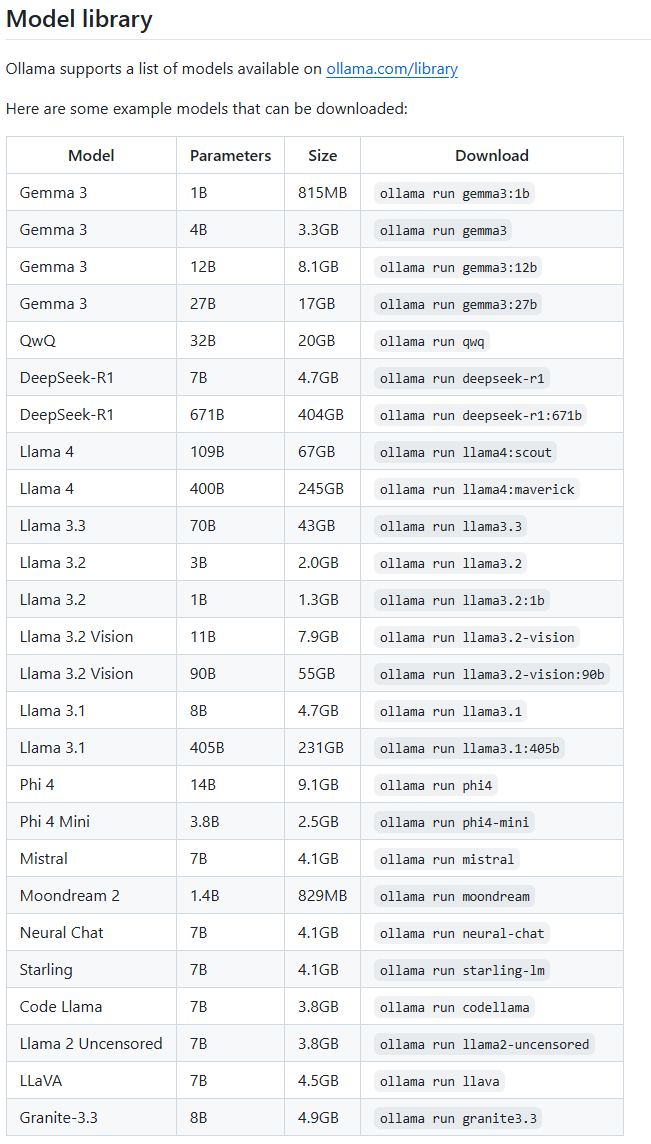

操作也简单,直接下载安装包,安装完成后执行命令运行(顺带就会先下载对应的模型),或者把 run 命令换成 pull,就只是下载模型

我就用的 Gemma3 4B,我的 RTX4060 Laptop 8G 显卡足够跑这个 4B 量化模型了,速度也相对较快。不建议使用 Deepseek,因为要输出思考过程,显得啰嗦,翻译也慢。

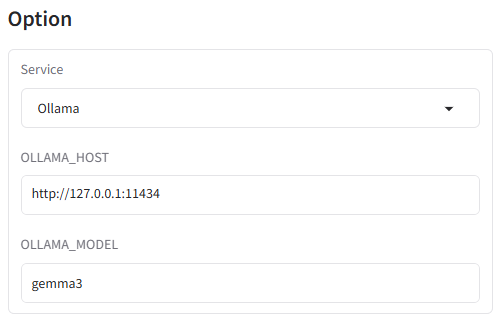

然后运行 PDFMathTranslate(使用 Ollama 时不要设置代理,否者执行翻译时会报错:“ERROR:pdf2zh.converter: (status code: 503)”)。然后 Service 选择 Ollama,OLLAMA_HOST 保持默认,OLLAMA_MODEL 填已下载的模型名称。